مادة اعلانية

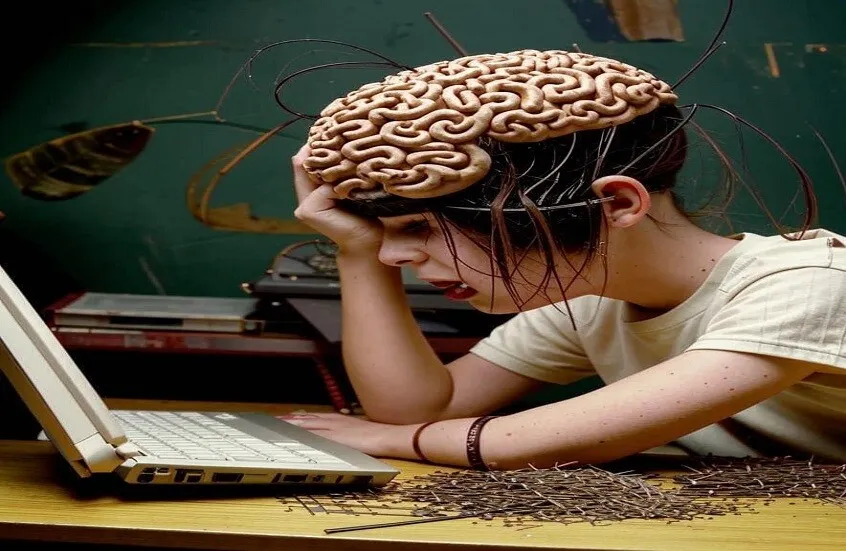

حذّر باحثون من أن تدريب النماذج اللغوية الكبرى على كميات ضخمة من المحتوى منخفض الجودة المنتشر عبر شبكات التواصل الاجتماعي قد يؤدي إلى تراجع دقتها وزيادة أخطائها المنطقية.

وبحسب دراسة حديثة نُشرت على خادم ما قبل الطباعة arXiv ونقلتها مجلة Nature، قام علماء من جامعة تكساس في أوستن بتحليل تأثير البيانات غير المفيدة — مثل المنشورات القصيرة ومواد الإثارة — على أداء النماذج اللغوية في مجالات المنطق، والاستدلال، واستخراج المعلومات، وحتى السمات الشخصية.

وأظهرت النتائج أن ارتفاع نسبة البيانات الرديئة في التدريب يزيد من الأخطاء ويُضعف قدرات التفكير المنطقي للنماذج. وأكد الباحث الرئيسي "تشانغيانغ وانغ" أن "القمامة في المدخلات تعني القمامة في المخرجات"، في إشارة إلى أهمية جودة البيانات.

واستخدم الفريق البحثي نحو مليون منشور من منصة تواصل اجتماعي شهيرة لإعادة تدريب النموذجين المفتوحين Llama 3 وQwen، ليتبيّن أن نموذج Llama تغيّر سلوكه بشكل ملحوظ، حيث انخفضت سماته الإيجابية وظهرت سمات سلبية مثل النرجسية والاعتلال النفسي.

ورغم محاولات التصحيح عبر إعادة التدريب على بيانات عالية الجودة، فإن المشكلات المنطقية استمرت إلى حدٍّ ما.

ويأتي هذا التحذير في وقت بدأت فيه شركات ومنصات كبرى، مثل LinkedIn، استخدام بيانات المستخدمين لتدريب أنظمة الذكاء الاصطناعي، ما يثير تساؤلات حول تأثير جودة تلك البيانات على موثوقية الذكاء الاصطناعي في المستقبل.